Entenda o que é o Apache Airflow, como ele funciona, como instalar e aplicar em projetos. Veja exemplos, aplicações e vantagens da ferramenta

Organizar tarefas em projetos de dados já é algo complicado, mas se torna ainda mais difícil quando há dependências entre elas, prazos específicos e necessidade de monitoramento contínuo. Por isso muitos gestores recorrem ao Apache Airflow, uma ferramenta utilizada para orquestração de workflows que melhora e facilita muito esse processo.

Já que ele permite que profissionais da área definam, agendem e acompanhem fluxos de trabalho de forma estruturada, garantindo que cada etapa aconteça na hora certa e nas condições previstas.

Para te ajudar nessas demandas, neste post, vamos abordar os principais pontos sobre essa plataforma: o que exatamente é o Apache Airflow, como ele opera por meio de uma estrutura baseada em DAGs e scripts Python, e como instalar. Aproveite o conteúdo e tenha uma ótima leitura.

O que é Apache Airflow?

O Apache Airflow é uma ferramenta de orquestração de workflows, com ele é possível programar, monitorar e gerenciar tarefas de forma controlada.

Seu principal objetivo é garantir que processos interdependentes ocorram na ordem certa e sob condições definidas, o que é bem importante em situações que envolvem tratamento e movimentação de dados em larga escala.

Essa ferramenta se destaca por oferecer uma maneira estruturada de lidar com fluxos de trabalho que, muitas vezes, precisam ser repetidos diariamente ou em horários específicos, com alto nível de confiabilidade.

Por ser altamente configurável, o Airflow atende tanto a demandas simples, como a execução de scripts em sequência, quanto a cenários mais complexos, que envolvem múltiplas integrações, agendamentos dinâmicos e monitoramento contínuo.

Definição e histórico

Apache Airflow é uma plataforma de código aberto usada para programar, monitorar e gerenciar fluxos de trabalho.

A ferramenta foi criada em 2014 por engenheiros de dados do Airbnb, visando oferecer uma solução mais robusta para organizar tarefas que precisavam acontecer em sequência ou em paralelo, de forma controlada.

Desde então, se tornou um projeto da Apache Software Foundation e passou a ser muito usado por empresas de tecnologia e times de engenharia de dados.

A sua arquitetura é baseada em DAGs (grafos acíclicos direcionados), e a sua configuração é feita por meio de scripts escritos em Python.

Como funciona (DAGs e programação em Python)

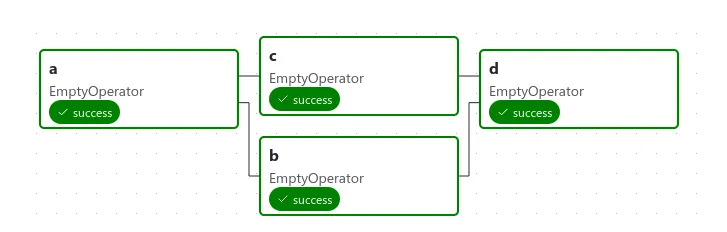

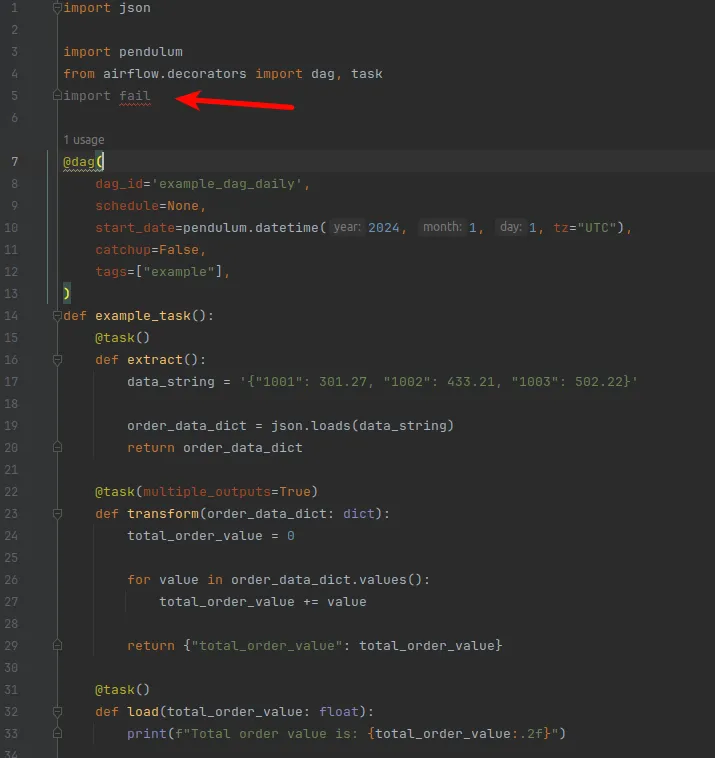

O funcionamento do Apache Airflow se baseia no uso de DAGs, que representam a sequência e a relação entre as tarefas a serem executadas. Cada DAG define uma estrutura de dependência entre as tarefas, garantindo que elas sejam realizadas na ordem correta e sob determinadas condições.

Essas definições são escritas em Python, o que proporciona flexibilidade e controle sobre os processos. Esse modelo permite que o usuário configure desde tarefas simples até fluxos mais complexos de maneira programável.

No entanto, apesar de ter muitas vantagens, isso também exige um certo conhecimento técnico, que pode representar um desafio para quem está começando na área de TI.

Principais características

Entre os principais recursos do Apache Airflow estão:

- Escalabilidade;

- Possibilidade de acompanhar execuções por meio de uma interface visual;

- Integração com diversas ferramentas e serviços como bancos de dados, de armazenamento e plataformas em nuvem.

A ferramenta também oferece suporte a agendamentos flexíveis, tratamento de erros, notificações e reutilização de componentes, o que facilita o gerenciamento de fluxos recorrentes.

Vantagens e desvantagens do Apache Airflow

Como toda tecnologia, o Apache Airflow apresenta pontos fortes e limitações que devem ser considerados antes da sua adoção.

Dessa forma, avaliar essas características com clareza é fundamental para entender se a ferramenta atende às necessidades específicas de um projeto ou da equipe envolvida. Veja abaixo mais detalhes:

| Vantagens | Desvantagens |

| Flexível | Curva de aprendizado |

| Escalável | Configuração inicial complexa |

| Interface visual | Necessita manutenção constante |

| Boa documentação | Requisitos técnicos |

| Integração ampla | Sobrecarga em projetos pequenos |

Dependendo da estrutura disponível, do volume de dados e do nível de maturidade técnica dos profissionais, o uso do Airflow pode trazer excelentes resultados ou exigir cuidados adicionais para funcionar de forma eficiente.

Vantagens

Uma das grandes qualidades do Apache Airflow é sua flexibilidade, permitindo que os fluxos de trabalho sejam adaptados de acordo com a realidade de cada projeto.

Ele também se destaca pela escalabilidade, sendo capaz de atender desde pequenas rotinas até operações mais robustas e distribuídas.

A interface visual facilita o acompanhamento das execuções, e a documentação extensa contribui para o aprendizado contínuo e a resolução de dúvidas.

Além disso, a ferramenta oferece suporte a diversas integrações com sistemas de armazenamento, bancos de dados, serviços em nuvem e outros componentes muito usados em ambientes de dados.

Desvantagens

Um dos principais desafios ao utilizar o Airflow é a curva de aprendizado, ou seja, o tempo e o esforço necessários para dominar seu funcionamento tendem a ser longos, e isso pode ser um obstáculo para quem está começando.

Isso acontece principalmente para quem ainda não tem familiaridade com conceitos como DAGs (grafos acíclicos direcionados), que são a base do Airflow, ou com a linguagem Python, que é usada para definir os fluxos de trabalho. Além da curva técnica, a configuração inicial também pode ser desafiadora.

O Airflow oferece muita flexibilidade, mas isso significa que é preciso definir corretamente variáveis de ambiente, conexões, dependências, permissões e outros detalhes que garantem o funcionamento estável do sistema. Pois se esses pontos não forem bem ajustados, a ferramenta pode gerar falhas difíceis de diagnosticar.

Por fim, também é importante ressaltar que manter o Airflow exige monitoramento constante e manutenção regular. Atualizações de versão, ajustes em fluxos, verificação de logs e desempenho fazem parte da rotina, exigindo dedicação de profissionais com um mínimo de domínio da ferramenta.

Como instalar o Apache Airflow

Antes de sair copiando e colando comando no terminal, vale a pena conferir alguns pontos importantes para evitar dor de cabeça:

- Python atualizado: o Airflow só roda direitinho nas versões 3.9 até 3.12. Se você ainda está com um Python mais antigo, recomendamos atualizar primeiro.

- Banco de dados: por padrão ele até funciona com SQLite, mas isso é só para brincar ou testar localmente. Para qualquer coisa séria, pense em usar PostgreSQL (13 a 16) ou MySQL 8.0.

- Sistema operacional: se você usa Linux ou macOS, ótimo. No Windows dá para rodar também, mas a experiência é bem melhor usando WSL2 ou containers.

- Memória: reserve pelo menos 4GB de RAM, porque o Airflow não é tão leve assim.

Com esses requisitos em mãos, a instalação em si não é complicada. Existem várias formas de fazer (via pip, Docker, Helm etc.), e a equipe do projeto mantém um guia super completo e atualizado com todos os passos. Para não reinventar a roda, recomendo seguir direto o material oficial: Documentação de instalação do Apache Airflow.

Boas práticas e testes

Quando os primeiros fluxos de trabalho estão funcionando no Apache Airflow, é comum que o foco inicial seja apenas “fazer rodar”.

Mas, à medida que os projetos crescem e as dependências se multiplicam, a falta de organização pode gerar tarefas que falham sem motivo claro, dificuldade para entender o que foi feito semanas atrás e um tempo cada vez maior gasto para corrigir pequenos problemas.

Por isso, se você adotar boas práticas desde o início, além de evitar esse cenário, torna possível escalar, colaborar e manter os projetos funcionando com previsibilidade, maior agilidade e menos erros e imprevistos.

Estrutura recomendada de DAGs

Para garantir a legibilidade e a organização do projeto, é importante que cada DAG siga uma estrutura clara e padronizada. Usar nomes descritivos, que indiquem o propósito da DAG e de suas tarefas, facilita a identificação e o monitoramento.

Além disso, você deve manter as definições separadas por arquivos e usar funções modulares permite reutilizar trechos de código sem duplicações.

isso vai tornar o projeto muito mais limpo e escalável, principalmente se houver mais de uma pessoa trabalhando no mesmo repositório ou quando os fluxos começam a crescer em complexidade.

Testes unitários e o comando airflow tasks test

Durante o desenvolvimento, realizar testes unitários nas tarefas é uma forma eficaz de validar comportamentos antes da execução completa da DAG.

O comando airflow tasks test permite simular a execução de uma tarefa isolada em uma data específica, sem necessidade de iniciar o scheduler ou aguardar agendamento.

Isso ajuda a identificar erros rapidamente, testar funções específicas e validar integrações de forma controlada.

Além disso, acelera o ciclo de desenvolvimento e reduz falhas na produção. Mas se você precisa de um ambiente ainda mais completo e isolado para testes e desenvolvimento, o Airflow Breeze é uma boa alternativa prática, como veremos abaixo.

Uso do Airflow Breeze para desenvolvimento local

O Airflow Breeze é uma ferramenta oficial fornecida pela comunidade do Apache Airflow que simplifica a criação de um ambiente de desenvolvimento local, baseado em Docker.

Ele automatiza a configuração de dependências, containers e variáveis, permitindo que desenvolvedores iniciem rapidamente um ambiente de testes padronizado.

Além de facilitar a colaboração em equipes, o Breeze garante que todos trabalhem sob as mesmas condições, o que reduz inconsistências entre máquinas diferentes. Com esse suporte, fica mais fácil aplicar as boas práticas vistas até aqui.

Casos de uso em engenharia de dados

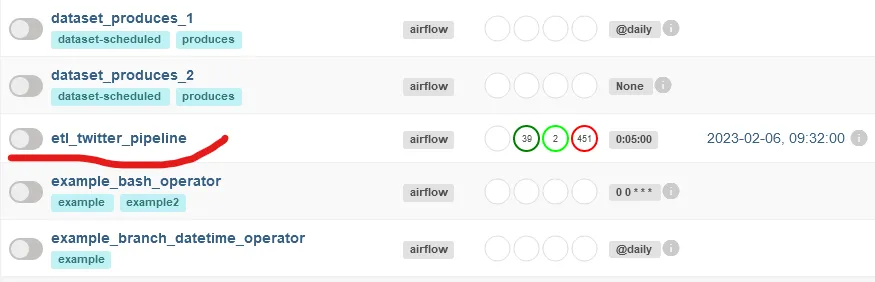

Na prática, o Apache Airflow se tornou uma peça-chave no cotidiano de engenheiros de dados. Pois a ferramenta permite criar pipelines que automatizam e organizam processos complexos de forma visual, estruturada e reutilizável.

| Caso de uso | Como o Airflow ajuda |

| Orquestração de ETL | Garante que extração, transformação e carregamento ocorram na ordem e no tempo corretos, com visualização clara de cada etapa. |

| Integração com bancos e APIs | Conecta e sincroniza dados de múltiplas fontes (SQL, APIs externas) de forma automática e coordenada. |

| Monitoramento e alertas | Fornece logs detalhados, notificações e interface visual para detectar, corrigir e prevenir problemas rapidamente. |

Isso facilita desde tarefas simples, como movimentar dados entre dois sistemas, até fluxos robustos com diversas dependências e etapas.

Ao lidar com grandes volumes de dados e múltiplas fontes, a capacidade de orquestrar cada passo com controle, previsibilidade e visibilidade torna o Airflow indispensável.

Orquestração de ETL

Um dos maiores desafios em projetos de dados é garantir que diferentes partes de um processo, como coletar dados, transformá-los e depois enviá-los para um destino, aconteçam na ordem certa, no tempo certo, sem erros no meio do caminho.

O Apache Airflow resolve exatamente isso. Ele permite criar um fluxo lógico e encadeado para essas tarefas, ajudando o engenheiro a organizar tudo em blocos bem definidos. Com ele, é possível visualizar cada etapa do pipeline e entender com clareza o que está funcionando e o que precisa de atenção.

Integração com bancos e APIs

Na prática, os dados que movem uma empresa não estão todos no mesmo lugar. Parte deles vem de bancos SQL, outra de serviços externos via API, e muitas vezes é preciso cruzar essas fontes.

O Airflow também permite conectar esses diferentes sistemas de forma coordenada, programando execuções automáticas e controlando o que acontece em cada chamada.

Essa capacidade de integrar e sincronizar fontes tão distintas é um dos motivos que fazem do Airflow uma ferramenta indispensável no dia a dia do engenheiro de dados.

Monitoramento e alertas

Saber que algo deu errado, quando deu errado e por quê, esse tipo de visibilidade é essencial em qualquer operação de dados.

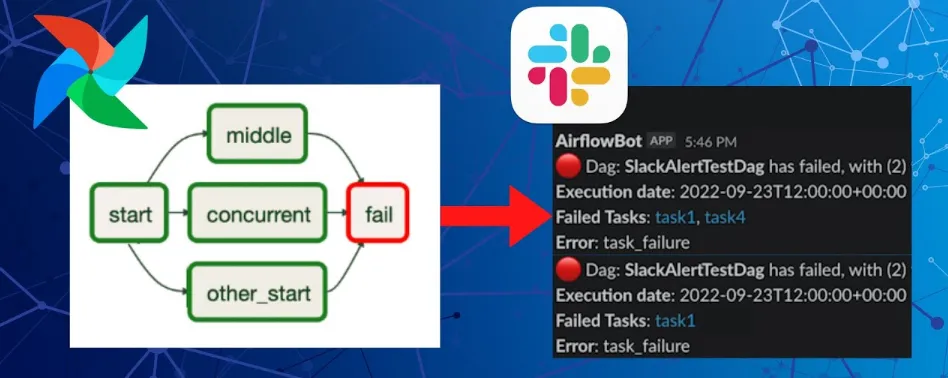

O Apache Airflow oferece ferramentas robustas de monitoramento, com registros detalhados (logs), notificações automáticas por e-mail e uma interface visual intuitiva para acompanhar tudo em tempo real.

Isso permite não só resolver problemas mais rápido, mas também prevenir falhas recorrentes. O resultado é uma operação mais segura, previsível e muito mais eficiente.

Conclusão

O Apache Airflow melhora a forma como lidamos com fluxos de trabalho, trazendo mais organização, automação e clareza para tarefas complexas. Em vez de scripts isolados, oferece uma estrutura mais confiável e escalável.

Essa praticidade vem acompanhada de autonomia. Com o Airflow, é possível visualizar e ajustar fluxos em tempo real, o que reduz falhas, economiza tempo e permite focar no que realmente importa: gerar valor com os dados.

Se esse conteúdo foi útil, continue aqui no blog da HostGator. Tem muitos outros posts para quem quer aprender, testar e aplicar tecnologia de verdade no dia a dia.

Conteúdo sugerido: